دیپ فیک (یا جعل عمیق) به فناوریای گفته میشود که با استفاده از هوش مصنوعی، بهویژه الگوریتمهای یادگیری عمیق (Deep Learning)، محتوای صوتی، تصویری یا ویدئویی را بهگونهای تولید یا دستکاری میکند که بسیار واقعی بهنظر برسد، در حالیکه در اصل جعلی است.

فناوری دیپ فیک معمولاً چهره یا صدای یک فرد را تقلید میکند و آن را به شکلی باورپذیر جایگزین فرد دیگری میسازد. برای مثال، در یک ویدئو، ممکن است صورت فردی را با صورت شخص دیگری جایگزین کنند یا صدای کسی را بهگونهای تقلید نمایند که گویی او واقعاً آن جملات را گفته است.

تکنولوژی دیپ فیک ابتدا در زمینه سرگرمی و سینما مورد توجه قرار گرفت، اما بهسرعت کاربردهای گستردهتری یافت؛ از تقلید صدا و چهره در شبکههای اجتماعی گرفته تا استفاده در تبلیغات، بازیهای ویدئویی، و حتی عملیات روانی و سیاسی.

در این مطلب خواهید دید که هوش مصنوعی دیپ فیک میتواند هم ابزار خلاقیت باشد و هم ابزاری برای فریب و سوءاستفاده، بسته به نیت استفادهکننده.

تاریخچه دیپفیک

آغاز شکلگیری دیپ فیک

ریشههای تکنولوژی دیپ فیک به پیشرفتهای دههٔ ۲۰۱۰ در حوزهٔ یادگیری عمیق و شبکههای مولد تخاصمی (GANs: Generative Adversarial Networks) بازمیگردد. در سال ۲۰۱۴، پژوهشگری به نام ایان گودفلو (Ian Goodfellow) برای نخستینبار معماری GAN را معرفی کرد. این معماری زیربنای اصلی هوش مصنوعی دیپ فیک شد، چرا که امکان تولید تصاویر و ویدئوهای کاملاً جعلی و مشابه واقعیت را فراهم میکرد.

نخستین کاربردهای عمومی

اصطلاح «دیپ فیک» برای نخستینبار در سال ۲۰۱۷ وارد فضای اینترنت شد. یک کاربر ناشناس در پلتفرم Reddit با نام کاربری deepfakes ویدئوهایی منتشر کرد که در آنها چهره بازیگران مشهور را بهصورت جعلی، اما بسیار واقعی، بر چهرهٔ افراد دیگر مونتاژ کرده بود. از آن زمان، واژهٔ دیپ فیک بهعنوان نام عمومی این فناوری رواج یافت.

توسعه و گسترش

با دسترسی عمومی به ابزارهای متنباز مانند FakeApp و بعدتر نرمافزارهایی مثل DeepFaceLab یا FaceSwap، فناوری جعل عمیق بهسرعت همهگیر شد. این ابزارها به افراد غیرمتخصص نیز اجازه میدادند با داشتن مقدار نسبتاً کمی از دادهٔ تصویری، ویدئوهای دیپ فیک بسازند.

ورود به سیاست و امنیت

از سال ۲۰۱۸ به بعد، نگرانیها نسبت به خطرات deep fake تکنولوژی شدت گرفت. ویدئوهایی از شخصیتهای سیاسی با محتوای جعلی منتشر شدند که در آنها افراد به گفتن جملاتی منتسب شده بودند که هرگز نگفته بودند. همین مسئله، زنگ خطر را برای نهادهای حقوقی، امنیتی و رسانهای بهصدا درآورد.

وضعیت کنونی

امروزه فناوری دیپ فیک همچنان در حال رشد و تکامل است. شرکتها و سازمانهای بزرگ در حال توسعهٔ ابزارهای مقابله با دیپ فیک هستند، در حالیکه سازندگان محتوا نیز از این تکنولوژی برای اهداف مثبت همچون بازسازی چهرهٔ بازیگران در فیلمهای تاریخی یا احیای افراد در مستندها استفاده میکنند.

در مورد ایان گودفلو…

ایان گودفلو کیست؟

ایان گودفلو (Ian Goodfellow) یک پژوهشگر و متخصص برجسته در حوزهٔ یادگیری ماشین و هوش مصنوعی است. او بیشتر بهخاطر ابداع شبکههای مولد تخاصمی (GANs) در سال ۲۰۱۴ شناخته میشود؛ معماریای که زیربنای اصلی بسیاری از فناوریهای جعل عمیق یا همان دیپ فیک است.

تحصیلات و سوابق دانشگاهی

- گودفلو دکترای خود را در حوزهٔ یادگیری ماشین از دانشگاه مونترآل (Université de Montréal) زیر نظر یوشوا بنجیو (Yoshua Bengio)، یکی از پیشگامان یادگیری عمیق، دریافت کرد.

- پیش از آن، مدرک کارشناسی و کارشناسیارشد خود را از دانشگاه استنفورد گرفته بود.

تجربیات شغلی

- او سابقهٔ همکاری با شرکتهای بزرگی مانند Google Brain، OpenAI و Apple را در کارنامه دارد.

- در شرکت گوگل، گودفلو نقش مهمی در توسعهٔ الگوریتمهای پیشرفتهٔ یادگیری ماشین ایفا کرد.

- در اپل، بهعنوان مدیر بخش یادگیری ماشین و امنیت فعالیت داشت.

اهمیت گودفلو در حوزه دیپ فیک

اگرچه گودفلو مستقیماً در ساخت محتوای دیپ فیک نقش نداشته است، اما ابداع GAN توسط او در سال ۲۰۱۴ باعث شد که فناوری دیپ فیک بعدها امکانپذیر شود. بههمیندلیل، نام او در تاریخچهٔ تکنولوژی دیپ فیک جایگاه ویژهای دارد.

دیپفیک دقیقا چگونه کار میکند؟

شبکهٔ مولد تخاصمی (GAN) مدلی از یادگیری عمیق است که از دو شبکه عصبی مجزا تشکیل میشود که در برابر یکدیگر قرار میگیرند و نوعی “بازی” یا “رقابت” بین آنها رخ میدهد. این دو شبکه عبارتاند از:

- مولد (Generator)

- تمییزدهنده یا تفکیکگر (Discriminator)

عملکرد گامبهگام GAN

۱. شبکهٔ مولد (Generator)

این شبکه وظیفه دارد دادهٔ جعلی تولید کند. برای مثال، تصویری که وجود خارجی ندارد اما شبیه چهرهٔ یک انسان واقعی است.

مولد از ورودی تصادفی (noise) شروع میکند و سعی میکند خروجیای ایجاد کند که تا حد ممکن واقعی بهنظر برسد.

۲. شبکهٔ تمییزدهنده (Discriminator)

این شبکه مانند یک بازرس عمل میکند. دادههایی که از مولد تولید میشود را با دادههای واقعی (مثلاً عکسهای واقعی از انسانها) مقایسه میکند و سعی دارد تشخیص دهد که کدام یک واقعی است و کدام جعلی.

۳. فرآیند یادگیری

- در ابتدا، شبکهٔ مولد تصویر ضعیف یا غیرواقعی تولید میکند.

- شبکهٔ تمییزدهنده بهراحتی تشخیص میدهد که تصویر جعلی است.

- مولد، بر اساس بازخورد تمییزدهنده، یاد میگیرد و تصویر بهتری تولید میکند.

- این فرایند بارها تکرار میشود و هربار، مولد تلاش میکند شبکهٔ تمییزدهنده را فریب دهد.

- در نهایت، مولد بهقدری پیشرفته میشود که خروجی آن بهسختی از واقعیت قابل تشخیص است.

نتیجهٔ این رقابت

در پایان آموزش، شبکهٔ مولد میتواند دادههایی تولید کند که بسیار واقعی بهنظر میرسند. این همان چیزیست که در ساخت ویدئوها و تصاویر دیپ فیک از آن استفاده میشود.

مثال کاربردی

فرض کنید میخواهید چهرهٔ فردی را جعل کنید:

- به GAN تعداد زیادی تصویر واقعی از آن فرد میدهید.

- شبکهٔ مولد یاد میگیرد که چطور چهرهٔ او را در حالات مختلف بسازد.

- شبکهٔ تمییزدهنده جلوی جعلهای ضعیف را میگیرد.

- در نهایت، خروجی شبکهٔ مولد یک چهرهٔ جعلی اما واقعنما خواهد بود.

موضع قانون در برابر دیپفیک

۱. ایالات متحده آمریکا

در برخی ایالتها، قوانینی مشخص برای مقابله با جعل عمیق تصویب شدهاند:

- تگزاس و کالیفرنیا از پیشگامان در این زمینه هستند. مثلاً در کالیفرنیا، انتشار دیپ فیکهای سیاسی در فاصلهٔ ۶۰ روز مانده به انتخابات ممنوع است.

- قانون دیگری در همین ایالت، اجازهٔ شکایت قربانیان دیپ فیکهای پورنوگرافیک را فراهم میسازد.

۲. اتحادیه اروپا

در چارچوب مقررات جدیدی بهنام قانون هوش مصنوعی اروپا (EU AI Act)، استفاده از deep fake تکنولوژی در حوزههای حساس مانند رسانه، تبلیغات و سیاست، ملزم به شفافیت است. به این معنا که:

- سازندگان باید بهصراحت اعلام کنند که محتوای تولیدشده واقعی نیست.

- در برخی موارد، درج برچسب «ساختهشده توسط هوش مصنوعی» الزامیست.

۳. چین

چین جزو کشورهاییست که سختگیرانهترین قوانین در زمینهٔ تکنولوژی دیپ فیک را وضع کرده است:

- از سال ۲۰۲۳، هرگونه تولید یا انتشار محتوای دیپ فیک باید ثبتنام رسمی داشته باشد.

- علاوهبراین، محتوا باید شامل نشانگذاری دیجیتال باشد تا مشخص شود که از طریق هوش مصنوعی دیپ فیک ساخته شده است.

۴. آلمان و دیگر کشورهای اروپایی

در آلمان و کشورهای شمال اروپا، قوانین حفظ حریم خصوصی و افترا، در صورت استفادهٔ مخرب از فناوری دیپ فیک قابل اعمال است. اما قوانین خاصی برای دیپ فیک بهصورت مستقل هنوز در حال تدویناند.

۵. قوانین بینالمللی و آیندهپژوهی

سازمانهایی مانند یونسکو و سازمان ملل نیز نسبت به مخاطرات جعل عمیق هشدار دادهاند. پیشنهادهایی برای تنظیم استانداردهای بینالمللی در حال بررسی است، اما هنوز به توافق جامع جهانی نرسیدهایم.

وضعیت کلی

در حال حاضر، بسیاری از قوانین مرتبط با دیپ فیک تازه در حال شکلگیری هستند. بیشتر آنها بر پایهٔ:

- افشای صریح جعلی بودن محتوا

- مجازات سوءاستفادههای سیاسی و جنسی

- حفظ حقوق افراد در برابر جعل هویت بنا شدهاند.

ابزارهای تولید محتوای دیپفیک

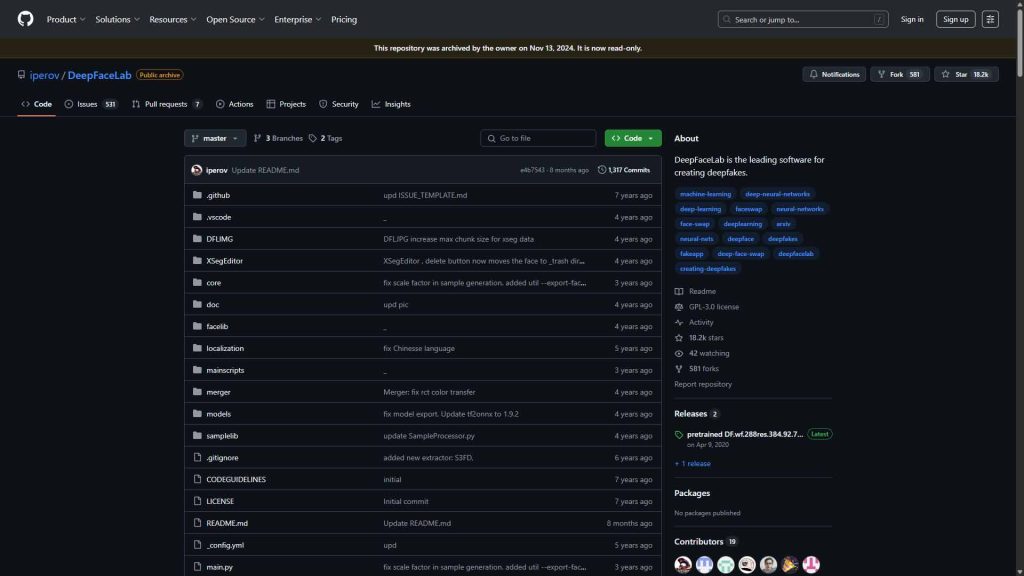

۱. DeepFaceLab

- نوع ابزار: نرمافزار متنباز (Open Source)

- ویژگیها: مناسب برای کاربران حرفهای؛ قابلیت جایگزینی چهره با دقت بالا

- دسترسی: قابل دانلود از GitHub؛ نیاز به دانش فنی بالا

- نکته: رایگان است اما نیاز به GPU قوی دارد

۲. Zao

- نوع ابزار: اپلیکیشن موبایلی چینی

- ویژگیها: تولید سریع ویدئوهای دیپ فیک با چهره شما روی بازیگران یا شخصیتهای مشهور

- دسترسی: نیاز به VPN برای نصب؛ در برخی نسخههای مارکتها قابل یافت است

- نکته: ساده و کاربرپسند؛ گاهی حریم خصوصی محل بحث است

۳. Reface App

- نوع ابزار: اپلیکیشن موبایلی محبوب

- ویژگیها: امکان جایگزینی چهره در گیف و ویدئو با کیفیت بالا

- دسترسی: قابل نصب از مارکتهای ایرانی یا با VPN از Google Play

- نسخه رایگان: دارد؛ برای کیفیت بالاتر نیاز به پرداخت درونبرنامهای

۴. D-ID (De-Identification)

- نوع ابزار: پلتفرم تحتوب

- ویژگیها: تبدیل تصویر به ویدئو سخنگو با لبخوانی مصنوعی؛ بسیار کاربردی در بازاریابی و آموزش

- دسترسی: وبسایت رسمی با امکان ساخت رایگان چند پروژه اولیه

- ویژه: مناسب برای تولید محتوای حرفهای با چهرههای انسانی زنده

۵. Synthesia.io

- نوع ابزار: پلتفرم ساخت ویدئوهای دیپ فیک سخنگو

- ویژگیها: تولید ویدئوهای رسمی با آواتار انساننما، پشتیبانی از زبانهای مختلف

- دسترسی: نیازمند ثبتنام و گاهی VPN؛ نسخه رایگان محدود

- کاربرد: بسیار مناسب برای ساخت محتواهای شرکتی و آموزشی

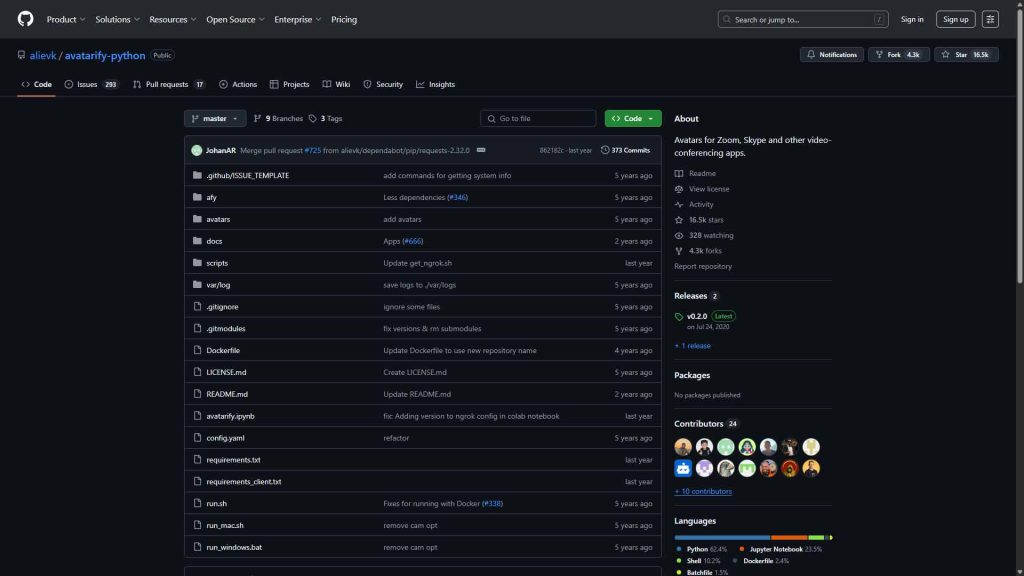

۶. Avatarify

- نوع ابزار: نرمافزار متنباز

- ویژگیها: استفاده در تماسهای تصویری برای تغییر چهره زنده

- دسترسی: قابل اجرا روی سیستمهای ویندوز و لینوکس؛ نیازمند دانش فنی

چند نکته مهم برای کاربران ایرانی

- بسیاری از این ابزارها نیاز به VPN دارند.

- در صورت استفاده از نسخههای غیررسمی اپلیکیشنها، حتماً به امنیت اطلاعات شخصی توجه داشته باشید.

- برای کاربردهای حرفهای، پیشنهاد میکنم از نسخههای دسکتاپ یا تحتوب معتبر مانند DeepFaceLab یا D-ID استفاده کنید.

راهنمای قدمبهقدم استفاده از فناوری دیپفیک

مسیر حرفهای: استفاده از نرمافزار DeepFaceLab

اگر بهدنبال خروجی با کیفیت بالا هستید و به سختافزار مناسب دسترسی دارید، این روش مناسبتر است.

پیشنیازها

- یک سیستم با کارت گرافیک NVIDIA (برای CUDA)

- سیستمعامل ویندوز

- دسترسی به نرمافزار DeepFaceLab (دانلود از GitHub)

- آشنایی پایه با کار با فایلهای تصویری و اجرای اسکریپتهای bat

گامهای تولید

گام اول: نصب نرمافزار

- به صفحه رسمی GitHub پروژه DeepFaceLab بروید.

- نسخهٔ متناسب با سیستم خود را دانلود و استخراج کنید.

گام دوم: آمادهسازی دادهها

- ویدئو یا تصاویری از فرد هدف (مثلاً بازیگر فیلم یا ویدئویی که میخواهید تغییر چهره دهید) را تهیه کنید.

- ویدئو یا تصاویری از خودتان نیز آماده داشته باشید.

گام سوم: استخراج فریمها

- با استفاده از اسکریپتهای پیشفرض موجود در DeepFaceLab، ویدئو را به فریمهای جداگانه (تصاویر) تبدیل کنید.

- سپس از هر فریم، چهرهها را با الگوریتمهای داخلی استخراج کنید.

گام چهارم: آموزش مدل

- مدل deep fake را با استفاده از مجموعه دادههای چهرهٔ منبع (خودتان) و هدف (فرد موجود در ویدئو) آموزش دهید.

- این مرحله زمانبر است و ممکن است چند ساعت تا چند روز طول بکشد، بسته به قدرت سختافزار شما.

گام پنجم: ترکیب و رندر نهایی

- پس از پایان آموزش، چهرهٔ خود را به جای چهرهٔ فرد موجود در ویدئو قرار دهید.

- ویدئو نهایی را رندر و ذخیره کنید.

مسیر ساده و سریع: استفاده از ابزارهای تحتوب مثل D-ID یا Reface App

مثال: ساخت ویدئو سخنگو با چهره خودتان در D-ID

این روش برای تولید ویدئوهای رسمی با چهره سخنگو بسیار ساده و قابلاستفاده حتی برای مبتدیهاست.

همچنین جالب است بدانید که گوگل نیز با مدل قدرتمند Veo وارد حوزه تولید ویدیو با هوش مصنوعی شده است. اگر میخواهید با این فناوری و تفاوت آن با دیپ فیک آشنا شوید، مقاله ویدیو هوش مصنوعی Veo گوگل چیست؟ را از دست ندهید.

در ادامه، مراحل ساخت ویدیو سخنگو با D-ID را مرحلهبهمرحله توضیح دادهایم:

گام اول: ثبتنام در سایت

- به آدرس https://www.d-id.com بروید و حساب کاربری بسازید. (ممکن است نیاز به VPN داشته باشید)

گام دوم: آپلود تصویر

- یک عکس پرتره واضح از خودتان بارگذاری کنید (پسزمینه خنثی بهتر است).

گام سوم: وارد کردن متن یا صدا

- میتوانید یک متن بنویسید تا آواتار شما آن را با لبخوانی بخواند، یا فایل صوتی خودتان را آپلود کنید.

گام چهارم: انتخاب زبان و صدا

- زبان را روی فارسی یا زبان دلخواه تنظیم کنید.

- صدای مصنوعی مناسب انتخاب کنید یا صدای واقعی خودتان را استفاده نمایید.

گام پنجم: تولید ویدئو

- چند ثانیه صبر کنید تا هوش مصنوعی دیپ فیک ویدئوی شما را بسازد.

- فایل را دانلود یا مستقیماً به اشتراک بگذارید.

مقایسه ابزارها

| ابزار | مناسب برای | مزایا | معایب |

| DeepFaceLab | کاربران حرفهای | کنترل کامل، خروجی دقیق | نیاز به سختافزار قوی و زمان |

| D-ID | تولید ویدئوی سخنگو | تحتوب، ساده، حرفهای | محدودیت در نسخه رایگان |

| Reface | سرگرمی و تولید سریع | موبایلی، بسیار آسان | کنترل پایین روی خروجی |

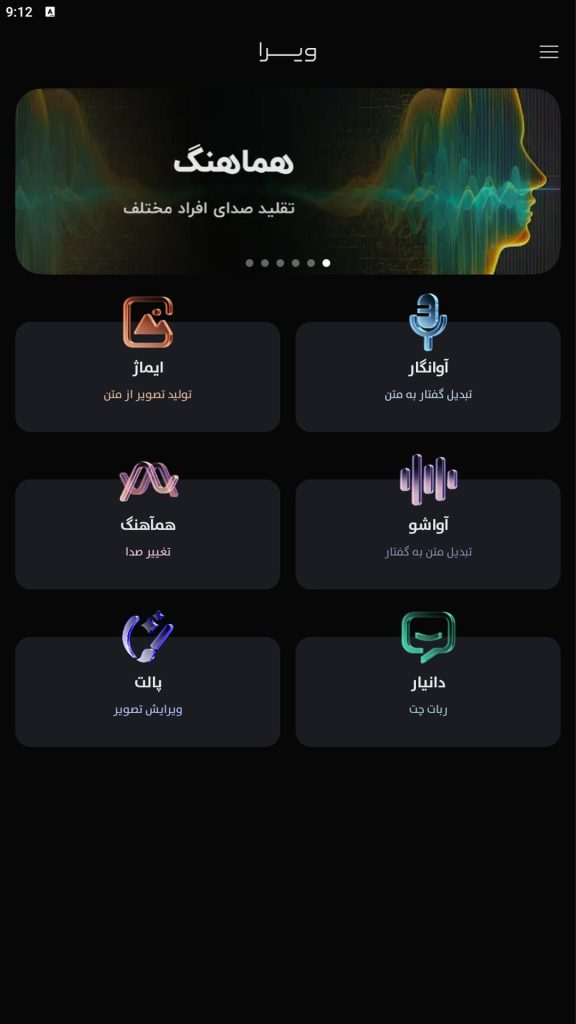

ویرا؛ دستیار هوشمند فارسیزبان

ویرا یک اپلیکیشن هوش مصنوعی فارسی است که کاملاً توسط مهندسان ایرانی طراحی و توسعه داده شده است. این اپلیکیشن، نخستین پلتفرم جامع بومی برای خدمات هوش مصنوعی است که از پاییز ۱۴۰۲ معرفی شده و تا امروز توانسته بیش از ۳ میلیون نصب و بیش از ۷.۹ میلیون درخواست را ثبت کند.

ویژگیهای شاخص ویرا:

- پشتیبانی از زبان فارسی و گویشهای مختلف آن

- ابزارهای تبدیل صوت به متن (آوانگار)، متن به گفتار (آواشو)، تبدیل متن به عکس (ایماژ)، چت با هوش مصنوعی (دانیار) و ویرایش تصویر (پالت).

- طراحی روان، موبایلی (اندروید از کافهبازار و مایکت)، آسان برای همهٔ کاربران ایرانی.

«همآهنگ»؛ تقلید صدای حرفهای

یکی از برجستهترین سرویسهای ویرا، همآهنگ است؛ سرویسی اختصاصی برای تغییر صدا—به گونۀ حرفهای و هوشمند.

چگونه کار میکند؟

- اپ ویرا را نصب میکنید (کافهبازار یا مایکت).

- وارد بخش «همآهنگ» میشوید .

- صدا یا فایل صوتی خود را ضبط یا بارگذاری میکنید.

- صدای شخصیتِ مشهور (مثل محسن چاوشی و دیگران) را انتخاب میکنید.

- روی تبدیل کلیک میکنید و نسخهای از صدای خروجی را دریافت میکنید .

صدای افراد سرشناس در همآهنگ

کاربران گزارش دادهاند که میتوانند صدای خود را به شبیهسازی صدای افراد سرشناس ایرانی تبدیل کنند. البته کیفیت نهایی بستگی به ضبط اولیه و شرایطش دارد . همچنین تأکید شده که استفاده از سرویس کاملاً قانونی بوده و قوانین رسمی کشور در آن رعایت شدهاست.

مزایای کلیدی ویرا

- کاملاً فارسیزبان و بومی: ویرا تنها اپ ایرانی است که همه سرویسها از جمله تقلید صدا را به فارسی ارائه میدهد.

- دسترسپذیر برای کاربران ایرانی: بهراحتی از اندروید قابل نصب است و برای بخشهایی هم به دلیل تحریمها ممکن است نیاز به VPN باشد.

- قانونی و اخلاقی: تاکید شده که استفاده از سرویس در چارچوب قوانین رسمی ایران است.

اصول اخلاقی و ملاحظات استفاده از دیپفیک

آینده فناوری دیپ فیک از منظر قانونی و اخلاقی

۱. شفافسازی اجباری

بسیاری از کشورها بهسمت الزام تولیدکنندگان محتوا به اعلام این نکته میروند که محتوای ارائهشده واقعی نیست و توسط هوش مصنوعی دیپ فیک تولید شده است. در آینده، ممکن است مانند «هشدار محتوای تبلیغاتی»، هشدار محتوای دیپ فیک نیز بهصورت الزامی روی ویدئوها یا فایلها درج شود.

۲. مجرمانهشدن سوءاستفادهها

انتظار میرود قوانین مشخصتری برای جلوگیری از

- جعل چهره یا صدای افراد بدون رضایت

- تخریب شخصیتهای عمومی

- استفاده در جعل مدارک، فتنههای سیاسی یا پورنوگرافی

وضع و اجرا شود. بسیاری از این موارد، در آینده در زمره جرایم سایبری یا افترا قرار خواهند گرفت.

۳. ایجاد ابزارهای شناسایی دیپ فیک

همزمان با پیشرفت این تکنولوژی، شرکتها و دولتها در حال توسعهٔ ابزارهای تشخیص خودکار جعل عمیق هستند. آیندهٔ فناوری دیپ فیک، به نوعی رقابت بین “جاعلان دیجیتال” و “بازرسان هوشمند” تبدیل خواهد شد.

نکات قانونی و اخلاقی که شما باید رعایت کنید

اگر شما قصد دارید از تکنولوژی دیپ فیک برای تولید محتوا استفاده کنید، توصیه میکنم این موارد را حتماً در نظر داشته باشید:

۱. رضایت افراد

هیچگاه از چهره یا صدای افراد واقعی، مخصوصاً شخصیتهای ناشناخته یا خصوصی، بدون کسب رضایت صریح و آگاهانه استفاده نکنید. حتی شوخیهای بیضرر ممکن است از نظر قانونی، مصداق نقض حریم خصوصی یا آزار دیجیتال تلقی شوند.

۲. عدم انتشار محتوای گمراهکننده

اگر محتوای شما به گونهای طراحی شده که ممکن است مخاطب تصور کند واقعی است، حتماً شفافسازی کنید که از فناوری دیپ فیک استفاده شده است. مثلاً در کپشن یا توضیحات بنویسید: “ساختهشده با هوش مصنوعی دیپ فیک؛ این صدا/تصویر واقعی نیست.”

۳. پرهیز از تقلید صدای افراد برای فریب یا سود

تقلید صدای اشخاص (مشهور یا غیرمشهور) با هدف فریبکاری، جلب اعتماد، کلاهبرداری یا ساخت دیالوگهای جعلی، غیراخلاقی و در بسیاری از کشورها غیرقانونی است.

۴. عدم استفاده در موضوعات سیاسی، امنیتی و جنسی

این سه حوزه، پرریسکترین کاربردهای دیپ فیک هستند. استفاده از دیپ فیک برای ساخت محتوای سیاسی، انتشار کلیپهای غیراخلاقی یا شبیهسازی چهرههای امنیتی/دولتی میتواند پیامدهای قضایی بسیار جدی داشته باشد.

۵. استفاده برای آموزش، سرگرمی یا هنر با اطلاعرسانی مناسب

اگر از این فناوری برای ساخت موسیقی، هنر دیجیتال، طنز، آموزش یا تبلیغ استفاده میکنید، با شفافیت کامل آن را معرفی کنید. این کار هم اعتماد مخاطب را جلب میکند و هم شما را از پیامدهای حقوقی احتمالی حفظ خواهد کرد.

جمعبندی

اگر علاقهمند به استفاده از فناوری دیپ فیک هستید، پیشنهاد میکنم رویکرد زیر را اتخاذ کنید:

- با هدف مثبت و خلاقانه تولید محتوا کنید

- از مدلهای چهره و صدای مجاز یا ساختگی استفاده کنید (مثلاً چهرههای مصنوعی با AI یا آواتار)

- همیشه برچسبگذاری و افشاگری شفاف داشته باشید

- آگاهانه از خطرات و پیامدهای حقوقی دوری کنید

لطفا نظرات خود را با من در میان بگذارید. قطعا خوشحال خواهم شد 🙂